CUDA 是什么

本文从比较宏观的角度来解释一下 CUDA 是什么,以及 CUDA 和 PyTorch 等支持 GPU 的工具之间的关系。

查看 CUDA 版本

先提一个问题:如何查看 CUDA 的版本?对于使用 PyTorch 的人而言,这可能是需要关注的问题,而我目前收到过这些答案:

-

nvidia-smi的右上角会显示 CUDA 版本 -

nvcc --version会输出 CUDA 的版本 -

python -c "import torch; print(torch.version.cuda)"是 CUDA 版本

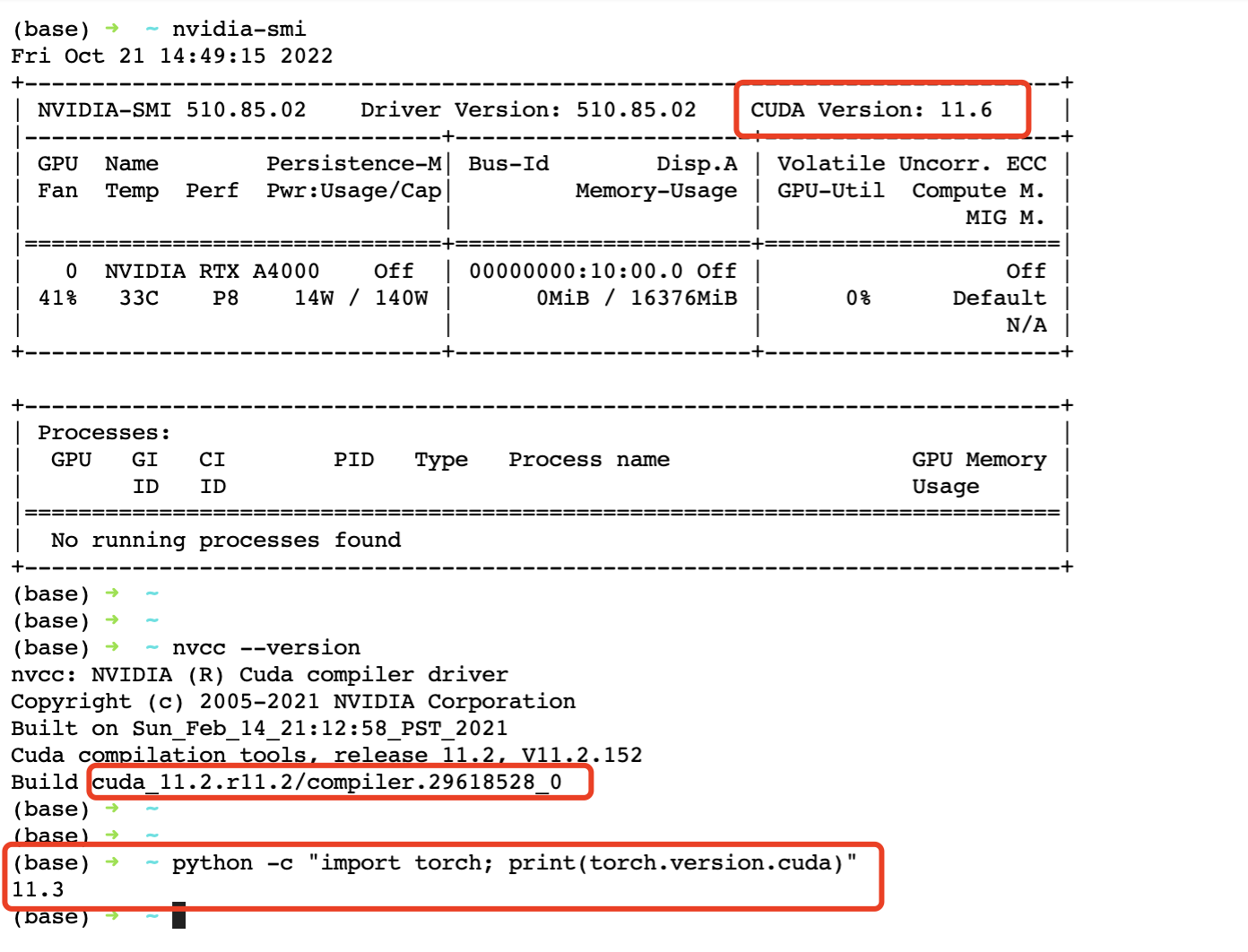

先放一张图:

这是同一个终端中用上面三种办法输出的 CUDA 信息,三个命令输出了三个不同的版本:11.6,11.2,11.3。是不是有点晕了?到底哪个是正确的「CUDA」版本呢。

其实「我的 CUDA 版本是什么?」这个问题本身就是不严谨的,大多数 PyTorch 使用者在问这个问题的时候,实际是想知道「我的 PyTorch 用的 CUDA 是哪个版本」,那么这个问题的答案是 3,也就是 python -c "import torch; print(torch.version.cuda)"。下面就来说说这三个命令为什么会有三种不同的输出。

nvidia-smi

这个命令一旦装完显卡驱动(nvidia-driver)就可以使用了,驱动程序提供最底层的程序接口,直接与硬件打交道。插上显卡的计算机也必须要装上驱动程序才能使用显卡。所以 nvidia-smi 的输出几乎都是显卡的硬件信息。

系统同一时间只能安装一个版本的驱动程序,如果安装多套版本可能会导致未定义的错误,另外驱动程序保持最新版本即可。

那这里的 CUDA Version 是代表什么呢?其实驱动程序也有 CUDA,叫做 Driver CUDA,这里指的是 Driver CUDA 的版本。而几乎所有的框架程序,所使用的 CUDA 都不是 Driver CUDA,而是 NVIDIA 提供的更上层的编程接口,叫做 「Runtime CUDA」。

nvcc 和 torch.version.cuda

首先 nvcc 是一个编译器,这个编译器是用户在安装 Runtime CUDA 的时候附带的。因此 nvcc 打印的是 Runtime CUDA 的版本。同样的,torch.version.cuda 打印的也是 Runtime CUDA 的版本,那这两个版本为什么也不同呢?我们需要先了解「Runtime CUDA」。

Runtime CUDA

Runtime CUDA 是 NVIDIA 封装的上层接口,几乎所有的应用程序,都是直接调用 Runtime CUDA 的 API,而 Runtime CUDA 内部调用 Driver 的接口。所以通常所说的 CUDA 都是指的 Runtime CUDA(除非是驱动开发的人员)。另外 NVIDIA 有一个规则,Runtime CUDA 的版本号必须小于等于 Driver CUDA 的版本号,所以 nvidia-smi 输出的 CUDA 版本可以理解为「该系统所能安装的最高 CUDA 版本号是多少」。

若无特殊说明,从下文开始 CUDA 都表示 Runtime CUDA

nvcc --version 输出的是当前安装的 CUDA 的版本,而系统同一时间还可以安装多套 CUDA,并且安装的方式还多种多样,一般来说有以下几种安装方式:

-

直接安装 PyTorch。

如果使用 PyTorch 几乎不用去考虑 CUDA 安装的问题,因为 PyTorch 本身自带 CUDA:

# 会自动安装 CUDA 10.2 pip3 install torch # 会自动安装 CUDA 11.3 pip3 install torch --extra-index-url https://download.pytorch.org/whl/cu113 # 会自动安装 CUDA 11.6 pip3 install torch --extra-index-url https://download.pytorch.org/whl/cu116有人可能会问:为什么装了 PyTorch 之后,没有

nvcc这个命令,或是nvcc --version显示的 CUDA 和 PyTorch 安装的 CUDA 版本对不上?上文说了,一个系统可能有多套 CUDA,如果

nvcc --version显示的 CUDA 对不上号,是因为系统本身安装了其他版本的 CUDA。另外,PyTorch 自带的 CUDA 只包含库文件,没有nvcc编译器,所以没有nvcc这个命令。 -

通过 Ubuntu 的官方源安装

sudo apt-get install nvidia-cuda-toolkit -

通过 conda 安装

conda search -c conda-forge cudatoolkit # 列出所有可以安装的版本 conda install -c conda-forge cudatoolkit=xx.x.x -

通过官方安装包

访问下面的链接,可以下载到不同版本的安装包:

不同安装方式安装的位置可能是不同的,例如 conda 是安装在 conda 的虚拟环境里,而官方安装包是装在 /usr/local/cuda 中,因此一个系统存在多份 CUDA 是完全有可能的。

如果还有人问「我的 CUDA 版本是什么?」,我们可以反问:

- 这里的 CUDA 说的是 Driver CUDA 还是 Runtime CUDA?

- 如果是 Runtime CUDA,那系统可能有多个,说的是哪个?用 apt-get 装的?PyTorch 自带的?还是 Runfile 装的?